数据结构

Promise

深度学习

typescript

两轮自平衡小车设计

MCAL

shell 实现

insert into

CMake include

433MHz自发电无线控制器

csp

最新版傻妞及Web安装教程

服务容错

自动装配原理之Starter

pinia

EDraw Max

Instagram

go mod init

项目实战

腾讯云服务器

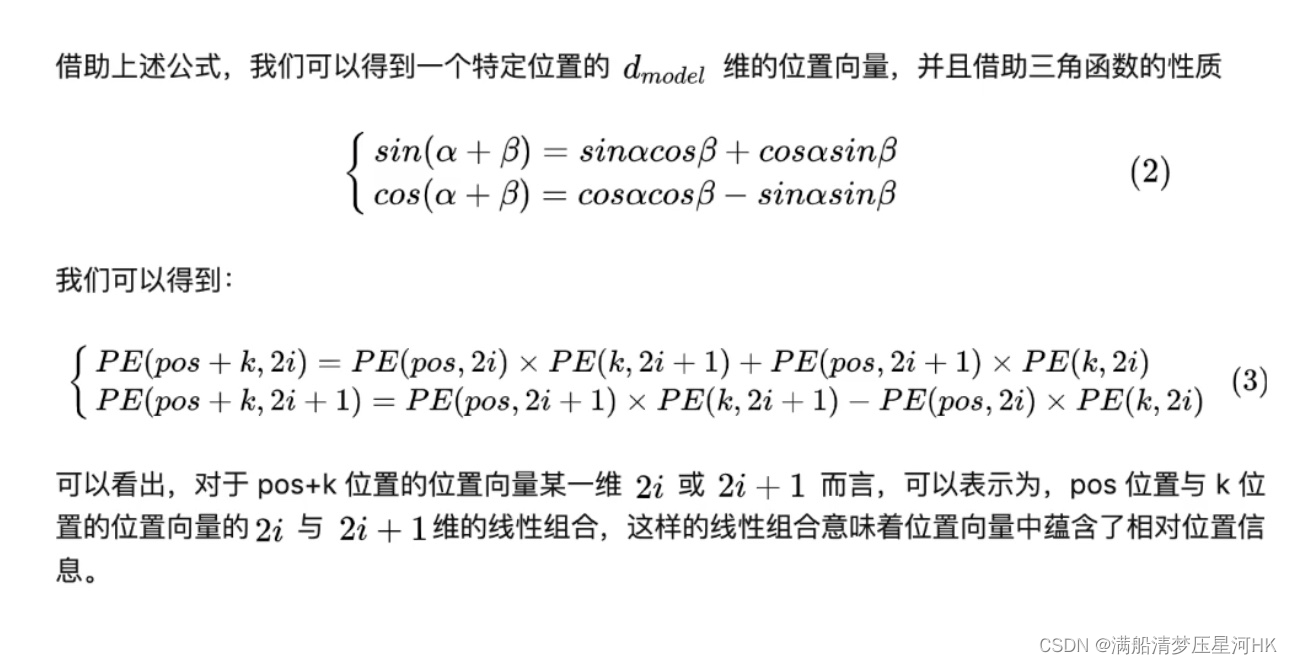

位置编码

2024/4/11 15:28:50【Transformer 相关理论深入理解】注意力机制、自注意力机制、多头注意力机制、位置编码

目录前言一、注意力机制:Attention二、自注意力机制:Self-Attention三、多头注意力机制:Multi-Head Self-Attention四、位置编码:Positional EncodingReference前言

最近在学DETR,看源码的时候,发现自己对…

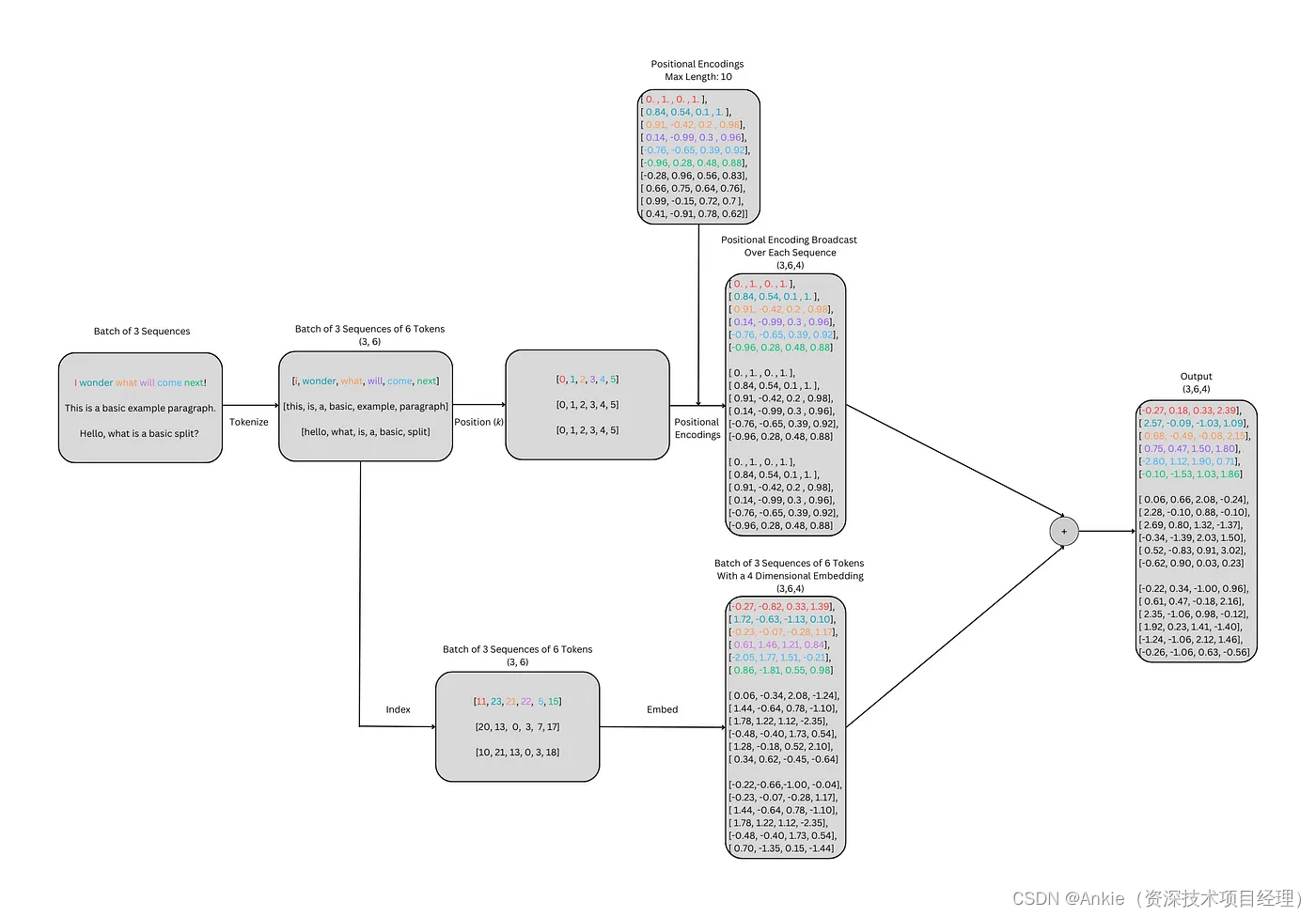

学习transformer模型-Positional Encoding位置编码的简明介绍

今天介绍transformer模型的positional encoding 位置编码 背景

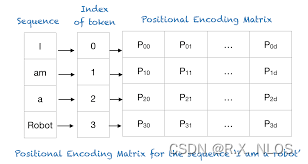

位置编码用于为序列中的每个标记或单词提供一个相对位置。在阅读句子时,每个单词都依赖于其周围的单词。例如,有些单词在不同的上下文中具有不同的含义,因此模型应该能够理解这…

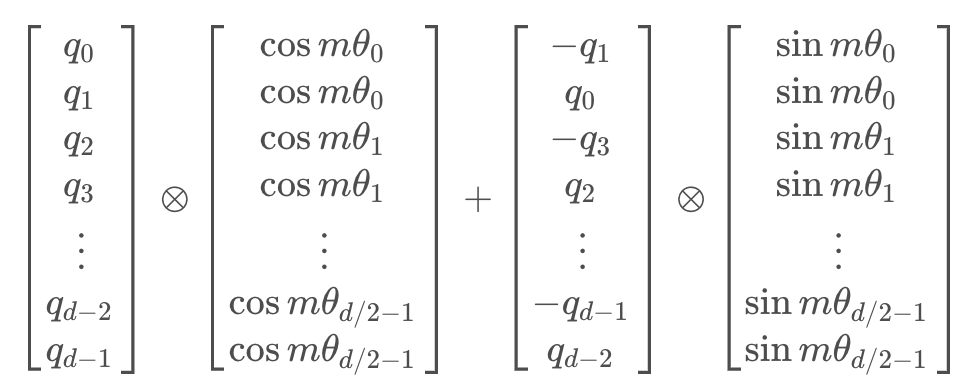

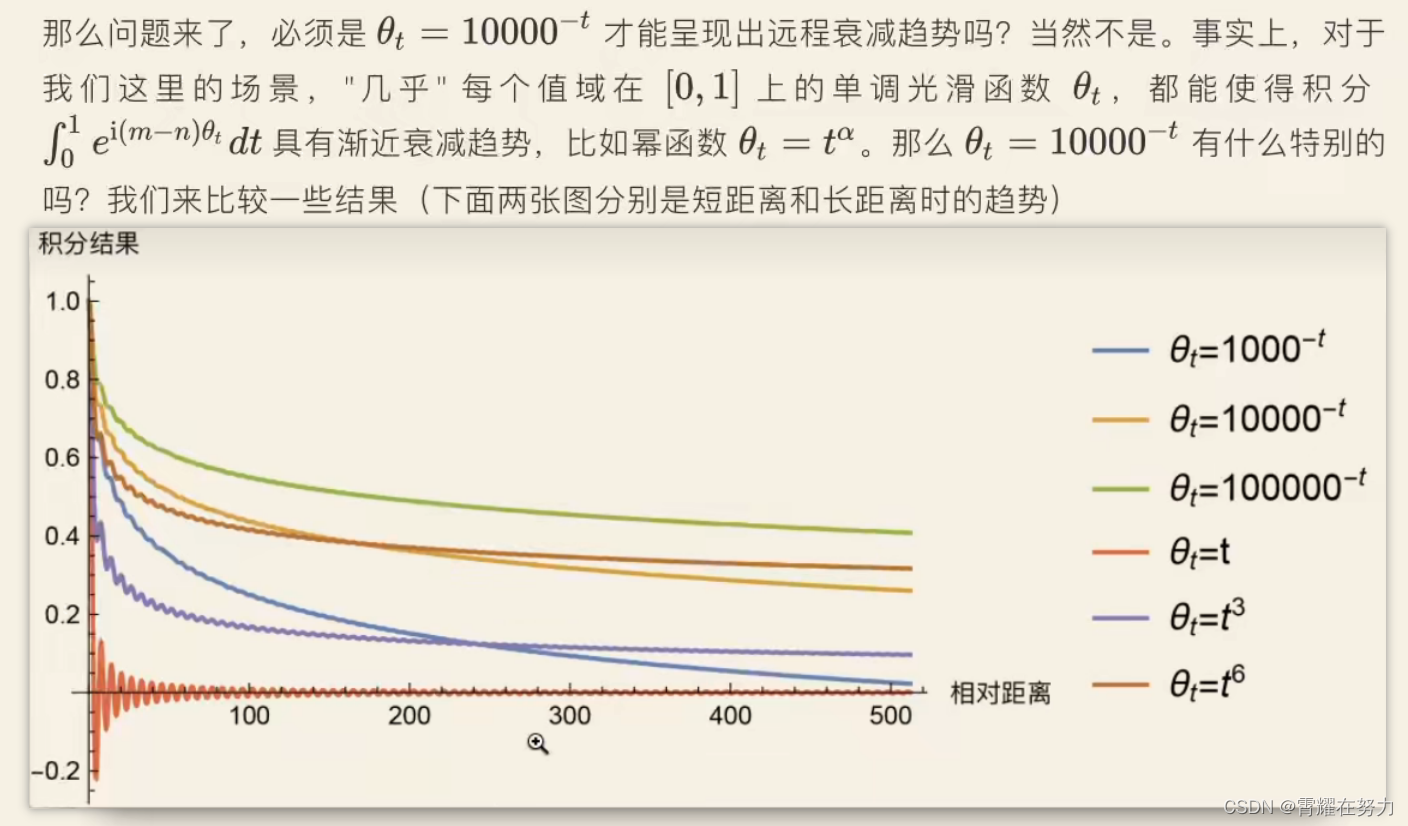

一文通透位置编码:从标准位置编码到旋转位置编码RoPE

前言

关于位置编码和RoPE

我之前在本博客中的另外两篇文章中有阐述过(一篇是关于LLaMA解读的,一篇是关于transformer从零实现的),但自觉写的不是特别透彻好懂再后来在我参与主讲的类ChatGPT微调实战课中也有讲过,但有些学员依然反馈RoPE不是…

关于SAM中decomposed Relative Positional Embeddings的理解

关于SAM中decomposed Relative Positional Embeddings的理解。

relative positional embedding的一种实现方式是:先计算q和k的相对位置坐标,然后依据相对位置坐标从给定的table中取值。以q和k都是77为例,每个相对位置有两个索引对应x和y两个…

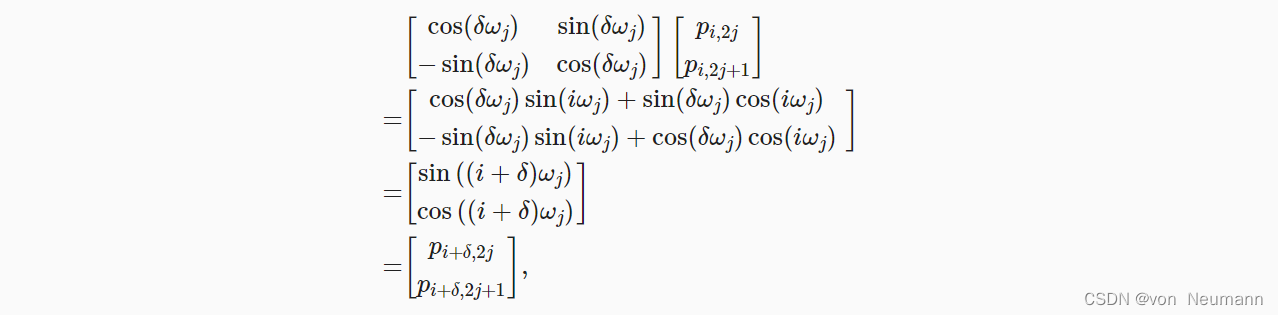

文献阅读:RoFormer: Enhanced Transformer with Rotary Position Embedding

文献阅读:RoFormer: Enhanced Transformer with Rotary Position Embedding 1. 工作简介2. 常见位置编码方式 1. 绝对位置编码 1. Bert2. Attention Is All You Need 2. 相对位置编码 1. 经典相对位置编码2. XLNet3. T54. DeBerta 3. RoPE方法介绍4. 实验效果考察 …

概念解析 | 神经网络中的位置编码(Positional Encoding)

注1:本文系“概念解析”系列之一,致力于简洁清晰地解释、辨析复杂而专业的概念。本次辨析的概念是:Positional Encoding 神经网络中的位置编码(Positional Encoding) A Gentle Introduction to Positional Encoding in Transformer Models, Part 1 1.背景介绍

在自然语言处理任…

decomposed Relative Positional Embeddings的理解

文章目录 正文文献来源 正文

relative positional embedding的一种实现方式是:先计算q和k的相对位置坐标,然后依据相对位置坐标从给定的table中取值。

以q和k都是77为例,每个相对位置有两个索引对应x和y两个方向,每个索引值的取…

Transformer的位置编码笔记(positional encoding)

一、为什么Transformer需要对输入进行位置编码因为Transformer的输入并没有内涵位置信息,同样的词在不同位置,或者同一个序列以不同顺序输入,对应的词间都会得到相同的注意力权重和输出,但是在NLP领域,词的顺序会极大地…

深入理解深度学习——注意力机制(Attention Mechanism):位置编码(Positional Encoding)

分类目录:《深入理解深度学习》总目录

相关文章: 注意力机制(AttentionMechanism):基础知识 注意力机制(AttentionMechanism):注意力汇聚与Nadaraya-Watson核回归 注意力机制&#…

【Transformer系列】深入浅出理解Positional Encoding位置编码

一、参考资料

一文教你彻底理解Transformer中Positional Encoding Transformer Architecture: The Positional Encoding The Annotated Transformer Master Positional Encoding: Part I 如何理解Transformer论文中的positional encoding,和三角函数有什么关系&…